Yapay Zeka (AI), çağımızın en çarpıcı buluşlarından biri olarak karşımıza çıkarken, bu alandaki gelişmeler aynı zamanda pek çok riski de beraberinde getiriyor. Bu riskleri anlamak ve kavramak için, “Pinokyo” masalından esinlenerek bir benzetme yapabiliriz. Masal, marangoz olan Geppetto usta tarafından tahtadan yaptığı Pinokyo’nun gerçek bir çocuk olma arzusuyla başlayan serüvenlerini anlatır. Geppetto ustanın saf niyeti ve yaratıcılığı, Pinokyo’nun bazen beklenmedik ve tehlikeli durumlarla karşılaşmasına neden olur. Yapay Zeka teknolojisi de, Pinokyo gibi kontrol edilmediği ve belli kurallar belirlenmediği sürece tehlikeli sonuçlar doğurabilir.

Yapay Zeka’nın Son Yıllardaki Gelişimi

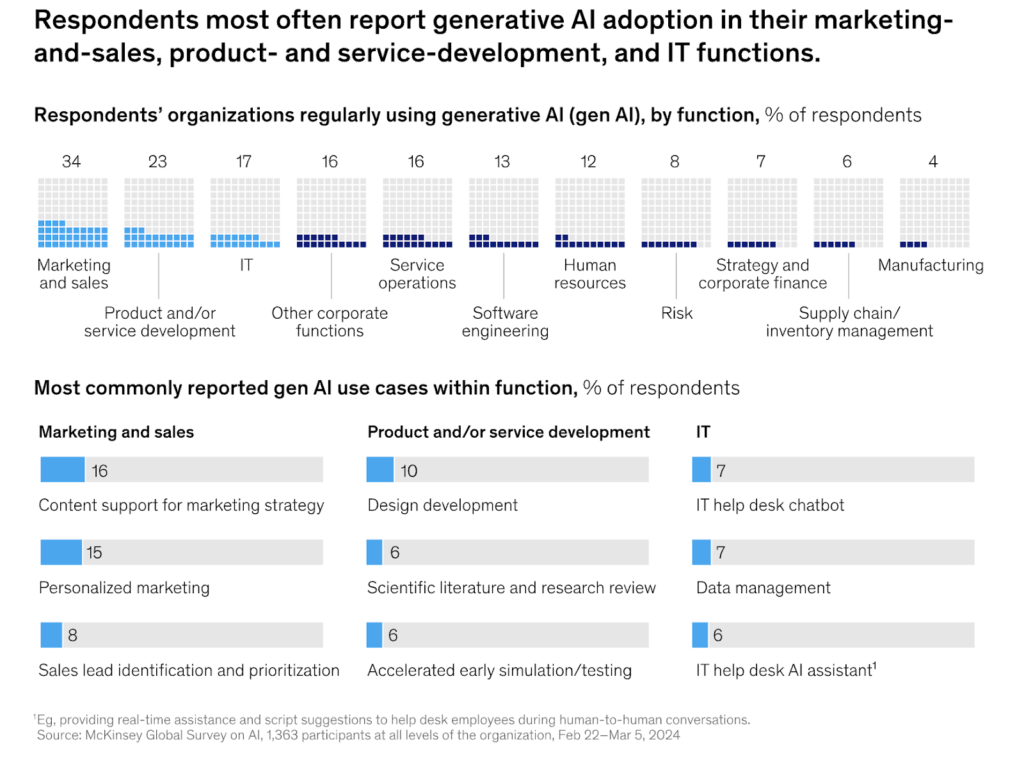

Son yıllarda, özellikle generatif Yapay Zeka alanında büyük ilerlemeler kaydedildi. McKinsey şirketinin raporuna göre generatif Yapay Zeka özellikle teknoloji ve finans sektörlerinde büyük bir dönüşüm yaratması bekleniyor. Bu teknolojinin, yazılım geliştirme sürecini hızlandırma potansiyeli pazarlama ve satış alanlarında önemli değer yaratabileceği belirtiliyor. Örneğin, generatif Yapay Zeka pazarlama optimizasyonu ve kişiselleştirilmiş müşteri etkileşimi gibi alanlarda büyük etkiler yaratabilir.

McKinsey şirketi tarafından paylaşılan grafikte generatif Yapay Zeka kullanımının farklı işlevlerde ve sektörlerde nasıl benimsendiğini göstermektedir. Görselde, en yaygın olarak pazarlama ve satış, ürün ve hizmet geliştirme ve IT fonksiyonlarında kullanıldığı görülmektedir.

Stanford Üniversitesinin AI Index 2024 raporunda, Yapay Zeka kullanımı dünya genelinde hızla arttığı ve birçok sektörde rekabeti şekillendirdiği vurgulanıyor. Rapora göre, Yapay Zeka’nın ekonomik etkisi yüksek teknoloji şirketlerinde ve bilgiye dayalı sektörlerde daha belirgin olduğu belirtilmektedir. Ayrıca, sağlık sektöründeki Yapay Zeka, ilaç geliştirme ve kişiselleştirilmiş tıp uygulamaları gibi alanlarda önemli faydalar sağlayacaktır.

Google şirketinin AI Sprinters raporuna göre ise, Yapay Zeka kullanımı, iş gücü üzerinde önemli değişiklikler yaratabilir. Raporda, Yapay Zeka araçlarının çalışanların verimliliğini artırdığı ve yeni beceriler kazanmalarını sağladığı belirtiliyor. Özellikle generatif Yapay Zeka araçlarının, yazılım geliştirme gibi teknik alanlarda büyük verimlilik artışları sağladığı gözlemlenmiştir.

Bu ilerlemeler, Yapay Zeka kullanımı geniş bir yelpazede uygulanabilirliğini ve gelecekteki potansiyelini ortaya koymaktadır. Ancak, bu teknolojilerin yaygınlaşmasıyla birlikte ortaya çıkan riskler de göz ardı edilmemelidir. Özellikle generatif Yapay Zeka kullanımı doğruluk, siber güvenlik ve fikri mülkiyet ihlalleri gibi konularda riskler taşıdığı ve bu risklerin yönetimi için etkili stratejiler geliştirilmesi gerektiği belirtiliyor.

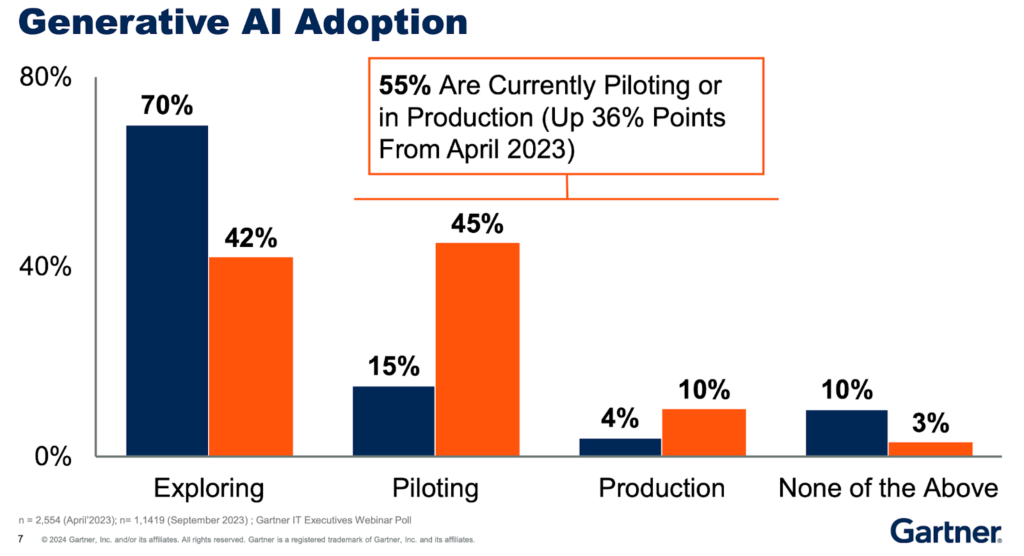

Gartner tarafından üst düzey BT yöneticileri arasında yapılan anket sonucu paylaşılan grafikte organizasyonların generatif Yapay Zeka kullanımını nasıl benimsediğini ve bu benimseme sürecinin aşamalarını göstermektedir. Görselde, organizasyonların büyük bir kısmının generatif Yapay Zeka’yı keşfetme ve pilot aşamasında olduğu, ancak üretim aşamasına geçenlerin sayısının da arttığı görülmektedir. Özellikle, organizasyonların %55’inin şu anda pilot uygulama veya üretim aşamasında olduğu belirtilmektedir. Bu da generatif Yapay Zeka kullanımının hızla benimsendiğini göstermektedir.

AB Yapay Zeka Yasası nedir?

Son yıllarda ChatGPT, Google Bard gibi üretken yapay zeka ürünlerinin ortaya çıkmasıyla birlikte yapay zekaya yönelik ilgi herkes tarafından arttı. Bununla birlikte yapay zeka üzerinden edinilen bilgilerde herhangi bir denetleme ve filtreleme olmaması da çeşitli tehlikeler ortaya çıkarmaktadır.

Avrupa Birliği Konseyi, dünya genelinde yapay zeka ile ilgili ilk kapsamlı düzenlemeleri içeren “Yapay Zeka Yasası”nın üye ülkeler tarafından onaylandığını duyurdu. Onaylanan yasa içerisinde, yüz tanıma veri tabanları oluşturmak için internetten veya CCTV görüntülerinden hedef gözetmeksizin yüz görüntülerinin alınması da dahil olmak üzere vatandaşların haklarını tehdit eden belirli yapay zeka uygulamaları yasaklanmaktadır. İş yerlerinde ve okullarda duygu tanıma, bir kişinin profiline veya özelliklerine dayalı tahmin eden, insan davranışını manipüle eden veya insanların zayıflıklarından faydalanan yapay zeka uygulamaları da yasaklanacaktır.

Kolluk kuvvetlerinin kullandığı biyometrik tanımlama sistemlerinin genel kullanımı yasaklanmış olup sadece belirli tanımlı durumlar için kullanımına izin verilmektedir. Bu belirli durumlara bir terör saldırısının önlenmesi gibi durumlar örnek verilebilir.

Yapay Zeka Yasasının Yürürlüğe Girmesiyle Temel Hedefler:

- Güvenlik ve Şeffaflık: YZ sistemlerinin güvenli ve şeffaf olmasını sağlamak.

- Temel Hakların Korunması: Bireylerin temel haklarının korunmasını sağlamak.

- Sorumluluk ve Hesap Verebilirlik: YZ sistemlerinin neden olduğu zararlar için sorumluluk ve hesap verebilirlik mekanizmaları oluşturmak.

- Yenilik ve Rekabetçiliği Teşvik Etmek: Yenilikçi YZ uygulamalarını teşvik etmek ve Avrupa’nın rekabetçiliğini artırmak.

Yapay Zeka Yasası ile Ne Yapılmak İsteniyor?

Yapay Zeka Yasası ile AB, Yapay Zeka teknolojilerinin etik ve güvenli bir şekilde kullanılmasını sağlamak istiyor. Yasa, yüksek riskli Yapay Zeka sistemleri için sıkı güvenlik ve şeffaflık gereksinimleri getirirken, düşük ve orta riskli sistemler için daha hafif düzenlemeler öngörmektedir. Ayrıca, yasa inovasyonu teşvik etmek ve Avrupa’nın Yapay Zeka alanında lider konumunu korumasını sağlamak için de önlemler içermektedir.

Öne Çıkan Unsurlar:

- Yüksek Riskli Sistemler: Sağlık, ulaşım ve hukuk gibi kritik alanlarda kullanılan Yapay Zeka sistemleri için sıkı düzenlemeler.

- Şeffaflık ve İzlenebilirlik: Yapay Zeka sistemlerinin nasıl çalıştığı ve kararlarının nasıl alındığı konusunda şeffaflık.

- Adil Rekabet: Yapay Zeka pazarında adil rekabetin sağlanması ve küçük ve orta ölçekli işletmelerin korunması.

- İnovasyonun Teşviki: Yapay Zeka alanında yeniliklerin teşvik edilmesi ve Avrupa’nın rekabet gücünün artırılması.

Yapay Zeka Uygulamalarının Kötü Yanları ve Hukuksal Sorunları

Olası Kötü Yanları

Yapay Zeka teknolojilerinin hızlı gelişimi, birçok alanda yenilikler getirmiştir. Ancak, bu teknolojilerin sunduğu avantajlarla birlikte, çeşitli kötü yanlar ve hukuksal sorunlar da ortaya çıkmaktadır.

Yapay Zeka teknolojilerinin kullanımının olası kötü yanları aşağıda listelenmiştir:

Gizlilik ve Güvenlik Riskleri: Yapay zeka sistemleri, büyük miktarda kişisel veri toplar ve işler. Bu, veri ihlalleri ve kötü niyetli saldırılar için risk oluşturabilir.

Yanlılık ve Ayrımcılık: Yapay zeka algoritmaları, eğitildikleri veri setlerindeki önyargıları yansıtabilir, bu da ayrımcılığa yol açabilir.

Kontrol Eksikliği: Yapay zeka sistemlerinin karmaşıklığı, onların nasıl çalıştığını ve kararlarını tam olarak anlamayı zorlaştırır.

Bağımlılık: İnsanlar, yapay zeka sistemlerine aşırı derecede güvenebilir ve bu da kritik düşünme ve karar verme becerilerinin zayıflamasına neden olabilir.

Olası Hukuksal Sorunlar

Yapay Zeka sistemlerinin karar alma süreçlerindeki şeffaf olmamak, hatalı veya yanlı sonuçlara yol açabilir ve bu da hukuksal sorumluluk meselelerini gündeme getirebilir. Yapay Zeka sistemlerinin yol açabileceği hukuksal sorunlar aşağıda listelenmiştir:

Sorumluluk ve Hesap Verebilirlik: Yapay zeka sistemleri hatalı kararlar verdiğinde veya zarara yol açtığında kimin sorumlu olacağı belirsizdir.

Veri Koruma Yasaları: Yapay zeka sistemleri tarafından işlenen kişisel verilerin korunması, GDPR gibi veri koruma yasaları ile uyumlu olmalıdır.

Fikri Mülkiyet Hakları: Yapay zeka tarafından oluşturulan içeriklerin sahipliği ve fikri mülkiyet hakları belirsizdir.

Otonom Sistemlerin Düzenlenmesi: Otonom araçlar ve robotlar gibi yapay zeka sistemlerinin kullanımının nasıl düzenleneceği konusunda yasalar geliştirilmelidir.

Kişi Haklarına Yönelik İstismarlar

Yapay Zeka teknolojilerinin kullanımı bireylerin temel hak ve özgürlüklerine yönelik istismar risklerini de beraberinde getirmektedir. Özellikle yüz tanıma sistemleri ve diğer biyometrik teknolojilerin kullanımı, mahremiyet ihlallerine ve ayrımcılığa yol açabilir.

Mahremiyet İhlalleri: Yapay zeka sistemleri, kişisel verileri toplama ve analiz etme yetenekleri nedeniyle bireylerin mahremiyetini ihlal edebilir.

Profil Oluşturma ve İzleme: Yapay zeka, bireylerin davranışlarını izleyerek profilleme yapabilir ve bu da gizlilik ihlallerine ve ayrımcılığa yol açabilir.

Adil Olmayan Kararlar: Yapay zeka sistemlerinin önyargılı veri setleri ile eğitilmesi, adaletsiz ve ayrımcı kararlar alınmasına neden olabilir.

Yapay Zeka ve GenAI Sisteminin Siber Güvenlik Sektöründeki Rolü

EU Act Etkileri

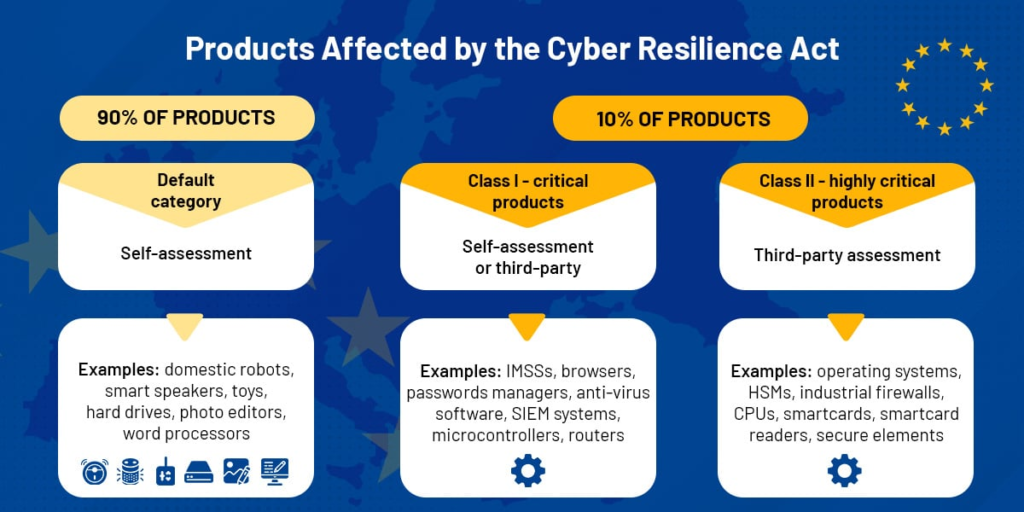

Avrupa Birliği (AB) 2024 Mart ayında onayladığı Yapay Zeka Yasası, siber güvenlik sektöründe önemli değişiklikler getirmesi beklenmektedir. Yasa, Yapay Zeka sistemlerini dört risk kategorisine ayırıyor: kabul edilemez, yüksek, sınırlı ve minimal risk. Bu sınıflandırma, Yapay Zeka sistemlerinin nasıl kontrollere tabi olacağını belirleyecektir.

Kabul Edilemez Risk Uygulamaları

Kabul edilemez risk taşıyan Yapay Zeka sistemleri yasaklanacak. Bu, sosyal puanlama sistemleri ve bazı öngörücü polislik türleri gibi uygulamaları içeriyor. Ayrıca, kamu alanlarında kullanılan Yapay Zeka tabanlı biyometrik tanımlama sistemlerinin çoğu da yasak kapsamına giriyor. Bu önlemler, kitlesel gözetimi önlemeyi ve temel hakları korumayı amaçlıyor.

Yüksek Risk Uygulamaları

Yüksek riskli Yapay Zeka sistemleri, kritik altyapılar, tıbbi cihazlar ve istihdam süreçlerinde kullanılan sistemler gibi alanlarda sıkı düzenlemelere tabi olacak. Bu sistemlerin, risk yönetimi, veri yönetişimi, teknik dokümantasyon ve şeffaflık gibi gerekliliklere uyması gerekiyor. Siber güvenlik sektöründe ki uygulamaların da kritik verilerle çalışıyor olmasından ve kritik altyapılarda çalışacak olmasından dolayı büyük bir çoğunluğunun yüksek riskli olarak sınıflandırılması beklenmektedir. Yapay Zeka sistemleri bu düzenlemelerle daha güvenilir ve doğru hale gelmesi beklenmektedir.

Siber Güvenlik Üzerindeki Etkisi

Yapay Zeka Yasası, siber güvenlik sektöründe katı standartlar getirecek. Kamu alanlarında gerçek zamanlı biyometrik tanımlama sistemlerinin kullanımı yasaklanacak ve bu, güvenlik firmalarını uyum sınırları içinde yenilik yapmaya zorlayacak. Bu durum, maliyetlerin artmasına yol açsa da, biyometrik teknolojilerin şeffaf ve güvenli kullanımını teşvik ederek tüketici güvenini artırabilir.

Uyum ve Yenilik

Siber güvenlik şirketleri, yeni düzenlemelere uyum sağlamak için kapsamlı risk değerlendirmeleri yapmalı ve Yapay Zeka operasyonlarını yasa ile uyumlu hale getirmelidir. Bu, Yapay Zeka dağıtım stratejilerinin yeniden gözden geçirilmesini ve yüksek veri koruma standartlarının korunmasını içerecektir.. Yapay zeka yasasına uyum sağlamada büyük ölçekli firmalar maliyetlerini finanse edebilir ancak küçük ölçekli şirketlerin bu maliyetlerin finansmanında zorluk yaşayabileceklerdir. Bu da Yapay Zeka uyumlu uygulamaları geliştirme yönünde yeniliği teşvik edebilir.

Yapay Zeka Uygulamaları ile Ortaya Çıkan Riskler

Yapay Zeka teknolojilerinin hızlı gelişimi, siber güvenlik alanında yeni ve karmaşık riskler ortaya çıkarmaktadır. Bu riskler, Yapay Zeka sistemlerinin geliştirilmesi, uygulanması ve sürdürülmesi sürecinde çeşitli şekillerde kendini gösterebilmektedir. Aşağıda, Birleşik Krallık hükümeti tarafından yayınlanan rapora istinaden hazırlanan Yapay Zeka kullanımı ile gelen bazı önemli siber güvenlik riskleri ortaya konulmuştur;

- Siber Saldırılar

Yapay Zeka, siber saldırıların hızını ve etkinliğini artırabilecek yeni yöntemlerin geliştirilmesine olanak tanımaktadır. Özellikle generatif Yapay Zeka, kişiye özel oltalama (phishing) yöntemleri veya kötü amaçlı yazılımların çoğaltılması gibi saldırıları daha sofistike hale getirebilir. Bu tür saldırılar, daha hedefli ve etkili olabilir. Çünkü Yapay Zeka, büyük miktardaki veriyi çözümleme yaparak zayıf noktaları tespit edebilir ve bu bilgileri kullanarak saldırıları en uygun hale getirerek gerçekleştirebilir.

- Dijital Güvenlik Açıkları

Yapay Zeka’nın kritik işlevler ve altyapılara entegrasyonu, yeni saldırı yüzeyleri yaratmaktadır. Eğitim verilerinin bozulması (“data poisoning”), model çıktılarının ele geçirilmesi (“prompt injection”) ve hassas verilerin açığa çıkarılması (“model inversion”) gibi yöntemler bu güvenlik açıklarının başlıcalarıdır. Bu tür saldırılar, Yapay Zeka sistemlerinin yanlış kararlar almasına veya manipüle edilmesine neden olabilir, bu da özellikle kritik altyapılar ve hizmetler için büyük bir tehdit oluşturur.

- Politik ve Toplumsal Etkiler

Yapay Zeka araçları, siyasi ve toplumsal konularda insanları ikna edebilme kapasitesine sahiptir. Bu, dezenformasyon ve yanlış bilgilendirme kampanyalarının ölçeğini ve etkisini artırabilir. Özellikle generatif Yapay Zeka, gerçekçi botlar ve “deepfake” kullanarak kamuoyunu yanıltabilir. Bu, sahte haberlerin yayılması, finansal piyasaların manipülasyonu ve adalet sisteminin zayıflatılması gibi riskler doğurur. Toplumsal kutuplaşmayı artırarak, kamuoyunun bilgilere olan güvenini sarsabilir.

- Güvenli Olmayan Kullanım ve Kötüye Kullanım

Yapay Zeka’nın kritik sistemlere entegrasyonu, veri sızıntılarına, yanlı ve ayrımcı sistemlere ve insan karar alma süreçlerinin zarar görmesine neden olabilir. Büyük ölçekli organizasyonlar tarafından uygunsuz kullanım, istenmeyen sonuçlar doğurabilir ve bu sonuçlar, sistemlerin performansında ciddi düşüşlere ve güvenlik açıklarına yol açabilir. Örneğin, Yapay Zeka modellerinin yanlış eğitim verileriyle eğitilmesi, sistemlerin yanlı veya hatalı kararlar almasına neden olabilir. Ayrıca, Yapay Zeka sistemlerinin şeffaf olmaması, karar süreçlerinde belirsizlik yaratabilir ve bu da güvenlik açıklarına yol açabilir.

Riskler ve Gelişmeler ile ilgili dikkat çekici haberler

- 4 Haziran’da, OpenAI ve Google Deepmind şirketinde çalışan ve çalışmış olan 13 kişilik bir grup, önde gelen yapay zeka şirketlerinin yapay zeka sistemlerini yeterince güvenli hale getirmek için yeterli çabayı göstermediğini bunun yerine kâr ve büyümeyi önceliklendirdikleri konusunda uyarıda bulunan açık mektup yayınladı.

- OpenAI şirketi, tüm OpenAI projeleri için kritik güvenlik ve güvenlik kararları hakkında tavsiyelerde bulunmak üzere yeni bir komite kurduğunu duyurdu.

- Siber güvenlik uzmanları, Windows Recall AI uygulamasının ekran görüntüsü aldığını ve bununda kolayca kötüye kullanılabileceği konusunda uyarıyor. Bir etik hacker, TotalRecall adında bir araçla Recall verilerini çıkardığını ve Recall uygulamasının veritabanının şifresiz olduğu için saldırganlar tarafından kolayca ulaşılabileceğini iddia etti.

- 200+ Özel GPT uygulamasında yapılan inceleme sonucunda tümünün “Prompt Enjeksiyon” saldırılarına açık olduğu ortaya çıktı.

- Google şirketinin yeni AI arama sonuçları, kötü amaçlı yazılım ve dolandırıcılık sitelerini tanıtıyor.

- Birleşmiş Milletler (BM) Genel Kurulu, güvenli yapay zeka sistemlerinin desteklenmesine ilişkin ilk karar tasarısını kabul etti.

- ABD ve Birleşik Krallık, yapay zeka güvenliği biliminde iş birliği yapmak için anlaşma imzaladı.

- Yapay Zeka Modellerinde Kötü Amaçlı Saldırı Riski: Wiz araştırması, Replicate adlı yapay zeka hizmet olarak sağlayıcıda kritik güvenlik açığı buldu.

- Salt Labs güvenlik firması ChatGPT eklentilerindeki güvenlik açıklarının üçüncü taraf hesaplaraa ve hassas verilere erişimine yol açtığını tespit etti.

- Ray AI Framework sistemi, binlerce sunucu tarafından yapılan saldırılar sonucunda hacklendi ve verileri ele geçirildi.

- Microsoft, Çinli bir hacker grubunun Tayvan’daki kuruluşları hedef aldığını ve AI kullanarak sahte haber yayınları oluşturmak için kullandığını bildirdi.

- HackerOne AI uygulamaları tarafından yapılan en yaygın 10 yapay zeka hatasını bu yazıda bir araya getirmiştir.

SANS CISO Primer: Yapay Zeka ve Gen AI Etkisi

2024 yılında, Yapay Zeka (AI) ve özellikle GenAI (Generative AI), siber güvenlik alanında önemli bir etki yaratacak teknolojiler olarak öne çıkıyor. Bu teknolojilerin hem risk kaynağı hem de güvenlik uygulamalarını geliştirme potansiyeli taşıdığı SANS tarafından yayınlanan raporda vurgulanıyor. Raporda öne çıkan konulara beraber bakalım.

- AI Sisteminin Yıkıcı Potansiyeli ve Risk Yönetimi: AI, özellikle GenAI, sadece siber güvenlikte değil, iş dünyası ve geniş teknoloji spektrumunda yıkıcı bir etki yaratma potansiyeline sahip. AI sisteminin sunduğu fırsatlar kadar, yeni riskler de bu teknolojiyle birlikte geliyor. CISO şirketi için AI kullanımını güvenli bir şekilde yönetmek, yeni teknolojiyi benimserken riskleri nasıl minimize edeceklerini dengede tutmak büyük önem taşıyor.

- AI Sistemlerinin Güvenli Entegrasyonu: AI sistemlerinin iş süreçlerine entegrasyonunda güvenlik, sistem geliştirme yaşam döngüsünün merkezine yerleştirilmeli. Özellikle AI tabanlı sistemlerin, başka iş araçları gibi güvenli bir şekilde korunması gerekiyor.

- GenAI Sisteminin İki Yönlü Kılıcı Olarak Rolü: GenAI, tehdit aktörlerinin taktiklerini güçlendirerek daha sofistike saldırılar yapmalarına olanak tanırken, aynı zamanda güvenlik takımlarının tehdit önleme, tespit ve yanıt verme süreçlerini otomatize ederek verimliliklerini artırma potansiyeline de sahip.

Özetle, 2024 yılında AI ve GenAI sistemlerinin siber güvenlikte nasıl bir rol oynayacağı, bu teknolojilerin potansiyellerini nasıl kullanıp risklerini nasıl yöneteceğimize bağlı olacak.